加速大模型生成式AI AMD EPYC不在话下

北京时间12月7日凌晨,AMD在圣何塞召开的“ADVANCING AI”大会圆满结束。

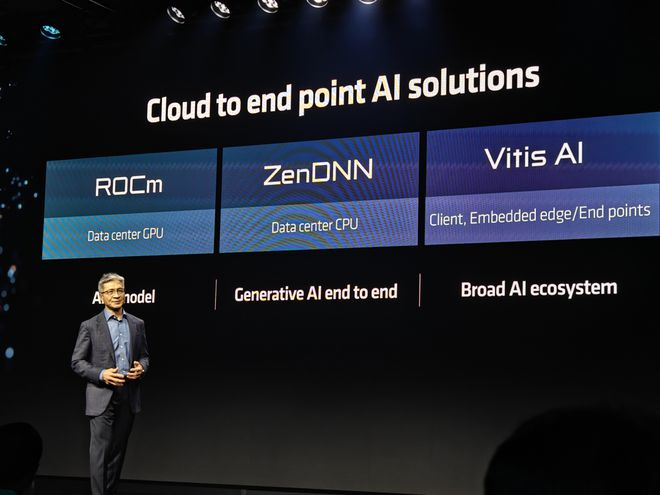

以AMD在会上谈到的AI策略来看,EPYC也显然是数据中心及AI策略里相当重要的一环,EPYC在生成式AI的端到端应用中能发挥很大作用。

先给大家回顾一下:今年6月,AMD在旧金山展示发布了代号“Geona-X”,新增3D V-Cache技术的第四代AMD EPYC 9004X系列处理器,进一步扩展了AMD EPYC 9004系列处理器在高性能技术计算应用方面的优势,提供了更好的x86 CPU解决方案。凭借多达 96个“Zen 4”内核和行业领先的惊人的1.1GB容量的L3 缓存,具有AMD 3D V-Cache技术的第四代AMD EPYC处理器可以显着提高客户在计算流体动力学(CFD)、有限元分析(FEA)、电子设计等技术计算工作负载中的性能和能效比,让用户可以使用更少的服务器和更低的TCO成本来满足需求。

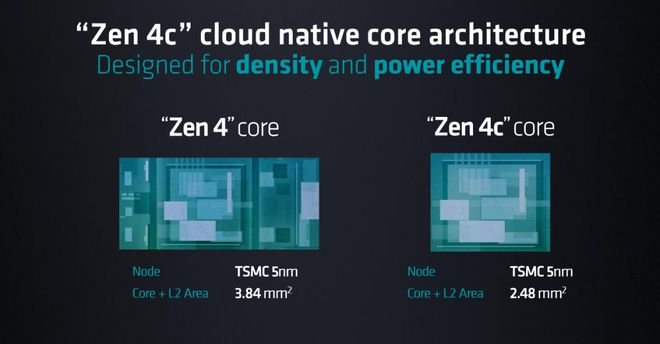

不仅如此,本次AMD还推出适应原生云计算需求,代号“Bergamo”的第4代AMD EPYC 97X4系列处理器。该系列处理器每个插槽最高可以提供128个全新的“Zen 4c”内核,可以为云计算应用程序提供更大的vCPU 密度和行业领先的性能。

“Zen 4c”内核为云原生应用环境而优化,通过适度减少Cache规模来使得核心面积减小35%,进而获得更高的核心密度和每瓦性能,将x86服务器处理器的单颗核心密度提升至128核,线程数提升至256线程,单CCD核心数提升至16核。AMD宣称,采用“Zen 4c”内核的第 4代AMD EPYC 处理器可以为客户将服务器端Java操作的能效比提升2.7倍,并将每服务器能提供的容器数量提升至3倍,可以以更高效率驱动更大规模的云原生应用程序。

值得注意的是,除了Cache规模不同、频率稍低,该系列处理器的其它规格与采用Zen 4核心的EPYC处理器并无不同,完全适应用户的各种兼容性需求。新产品发布之后,AMD 第四代EPYC系列处理器在核心IPC、每核Cache、核心密度、能效比和频率这五个维度上,针对用户的不同需求提供了更加细分的选择,进一步增强了该系列处理器的市场综合竞争力。

回到本次大会,我们在Demo区看到了EPYC平台与竞争对手的直接对比数据。

在AMD展示的测试环境下,1P的AMD EPYC 9374F(32核心)战胜了2P的竞争对手64核心平台,在机器学习时的AI吞吐量(Throughput)甚至可以达到竞争对手的2.25倍。

AMD也展示了在企业级大语言模型Liama 2中,实际操作同样命令的对比情况。EPYC 9654效率比对手高36%。这充分说明,如果是之前已经投资CPU的用户,在需要进行Training训练或者运行大模型服务时,仍然能获得同级不错的运行效率。EPYC也可以在LLM大模型领域发光发热。

内容转载于微型计算机

延伸 · 阅读

- 2024-03-11美式豪华再进化 全新电混林肯Z与全新电混林肯冒险家焕新上市

- 2024-03-06TEA WORLD FESTIVAL 2024 第27届国际茶文化大展

- 2024-02-24全场景智能驾驶再升级!星纪元ES首次大规模OTA,60+项功能重磅来袭

- 2024-02-03擦亮“金字招牌”,佛山照明获评“中华老字号”!

- 2023-12-26《我不是武则天》开机盛典,港澳台三地明星齐聚共襄盛举

- 2023-12-08加速大模型生成式AI AMD EPYC不在话下